Une porte logique quantique ne se comporte pas toujours de façon déterministe. Les algorithmes classiques échouent dès qu’ils doivent traiter des états superposés ou intriqués. L’apparente puissance des qubits s’accompagne d’une instabilité chronique, source d’erreurs systématiques.

Certaines corrections d’erreurs exigent plus de ressources que le calcul lui-même. Malgré les progrès récents, des limites physiques et théoriques freinent l’adoption généralisée des architectures quantiques. Les protocoles actuels s’ajustent en permanence pour composer avec ces contraintes.

Comprendre les bases de l’informatique quantique : concepts essentiels et enjeux

L’informatique quantique ne se contente pas d’améliorer les performances des ordinateurs traditionnels. Elle s’appuie sur la physique quantique pour attaquer des problèmes complexes jusqu’ici inaccessibles. Au cœur de cette révolution, le qubit fait voler en éclats la logique binaire classique. Grâce à la superposition et à l’intrication, des notions popularisées notamment par Richard Feynman et David Deutsch,, il ouvre le champ des possibles.

Les ordinateurs quantiques manipulent ces qubits via des algorithmes taillés sur mesure pour exploiter cette nouvelle dynamique. L’algorithme de Peter Shor promet de factoriser des entiers à une vitesse inatteignable avec les moyens classiques. Celui de Grover accélère la recherche dans des bases de données non structurées. Ces percées marquent le début d’une ère nouvelle dans le calcul quantique : le potentiel est immense, le changement de paradigme, radical.

Vers un avenir transformé

Trois axes majeurs esquissent le paysage du quantique moderne :

- Potentiel révolutionnaire informatique : le calcul quantique s’annonce capable de bouleverser la cryptographie, la simulation de matériaux et l’optimisation.

- Enjeux techniques : la maîtrise fine des algorithmes quantiques et la stabilisation des qubits restent des chantiers ouverts.

- Référence à la mécanique quantique : chaque avancée s’appuie sur des concepts venus de la physique fondamentale.

En moins de quarante ans, on est passé du concept d’ordinateur quantique à des processeurs capables de manipuler plusieurs dizaines de qubits. Ce bond spectaculaire suscite autant d’enthousiasme que de débats : la puissance de ces ordinateurs quantiques intrigue, leurs usages futurs restent à inventer.

Pourquoi l’informatique quantique rencontre-t-elle autant de défis ?

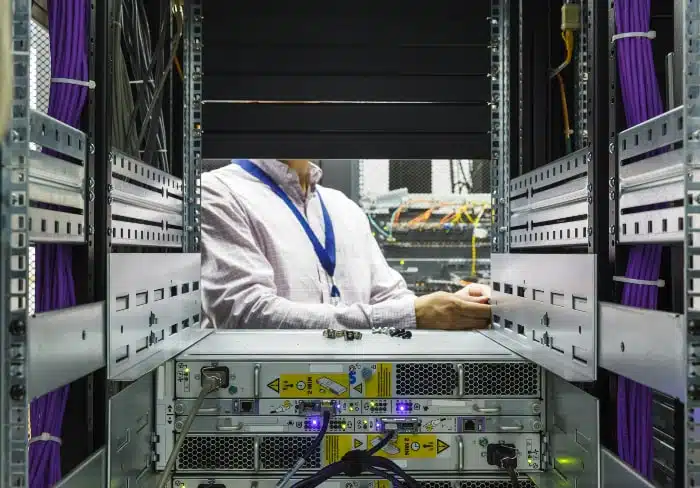

Le processeur quantique fascine, mais le chemin vers l’exploitation concrète du calcul quantique est semé d’embûches. Les démonstrations de Google, IBM ou Microsoft impressionnent, mais sous la surface, les obstacles se multiplient. La décohérence règne en maîtresse : le moindre incident, chaleur résiduelle, ondes parasites, microscopiques vibrations, menace l’intégrité des qubits et fait s’évaporer l’information.

La correction des erreurs quantiques impose une discipline de fer. Impossible de se reposer sur la simple redondance des systèmes classiques : la superposition et l’intrication rendent la tâche épineuse. Les laboratoires du Cea, du Cnrs et les équipes françaises mobilisées dans le cadre du Plan Quantique cherchent la parade en développant des modèles plus robustes. Mais chaque correctif consomme des qubits supplémentaires, au détriment de la puissance de calcul disponible.

Olivier Ezratty, observateur aguerri du secteur, souligne la fragilité extrême et la sophistication des architectures actuelles. Même les services cloud quantiques mis à disposition par les géants du numérique ne peuvent contourner totalement ces limitations. Sur un autre front, la cybersécurité informatique quantique se trouve propulsée au premier plan, sous le regard attentif de la Nsa. Face à la compétition mondiale, la France mise sur ses instituts de recherche et sa capacité à mobiliser ses talents.

Décryptage des principales causes des problèmes actuels

Impossible de contourner la décohérence : c’est elle qui ronge la stabilité des qubits. Dès qu’un qubit interagit avec son environnement, l’information quantique se délite. Ce phénomène, au cœur de la mécanique quantique, met à mal la fiabilité des calculs, qui deviennent parfois inutilisables en une fraction de seconde. Même les meilleurs laboratoires, du Cea au Nist, peinent à maintenir un état stable plus de quelques microsecondes.

Un autre mur se dresse : la correction des erreurs quantiques. Alors que l’ordinateur classique gère les pannes via des méthodes éprouvées, l’univers quantique impose des techniques infiniment plus pointues. Pour obtenir un seul qubit logique fiable, il faut coordonner et contrôler une multitude de qubits physiques, un coût énorme en ressources, qui plombe la puissance de calcul réellement exploitable. C’est le talon d’Achille actuel des ordinateurs quantiques.

Voici les autres verrous qui freinent le développement :

- Explicabilité : l’interprétation des résultats issus des algorithmes quantiques reste partielle. La superposition brouille la lecture des quantités de données produites, rendant l’analyse délicate.

- Problèmes d’intégration : les architectures hybrides, qui associent ordinateurs classiques et quantiques, soulèvent des défis inédits en matière de synchronisation et de transfert d’informations.

Un autre facteur ralentit la cadence : la pénurie d’experts capables de naviguer entre physique quantique et informatique. Les équipes, dans le sillage des pionniers comme Yuri Manin, visent une fiabilité accrue, indispensable pour s’attaquer à des problèmes complexes inaccessibles aux machines classiques.

Des solutions innovantes pour surmonter les obstacles et ouvrir de nouvelles perspectives

Pour s’attaquer à la fragilité des qubits et à la lourdeur de la correction des erreurs quantiques, plusieurs approches convergent. Les chercheurs multiplient les expérimentations avec des matériaux supraconducteurs, du silicium, ou encore des ions piégés. Chaque piste vise à améliorer la stabilité et à limiter l’effet de la décohérence. Mais la technique, aussi avancée soit-elle, ne suffit pas à elle seule.

L’intelligence artificielle prend désormais place dans la gestion des systèmes quantiques. Grâce à l’apprentissage automatique, la calibration des processeurs s’affine, les anomalies sont repérées plus vite. Des géants comme Amazon ou Nvidia, mais aussi des jeunes pousses à Paris ou Lyon, développent des outils capables d’exploiter les données issues du calcul quantique. Cette nouvelle génération d’outils rend l’informatique quantique plus accessible, aussi bien aux chercheurs qu’aux industriels.

Voici deux leviers qui changent la donne :

- Cryptographie post-quantique : le NIST, basé à Washington, structure de nouveaux standards pour protéger les communications face à la puissance des ordinateurs quantiques en devenir.

- Services cloud quantiques : IBM, Google et Microsoft ouvrent l’accès à leurs machines via le cloud, permettant à des équipes dispersées à travers le monde de travailler ensemble et de mutualiser leurs efforts.

En France, le Plan Quantique donne un coup d’accélérateur à la filière : il encourage l’émergence de nouveaux talents, finance des plateformes d’expérimentation et alimente une dynamique collective. Universités, laboratoires publics, industriels : tous avancent ensemble pour façonner l’avenir informatique quantique et développer des solutions hybrides de plus en plus robustes.

À mesure que la science des qubits progresse, les promesses se précisent, les obstacles se déplacent et les espoirs grandissent. Demain, ce sont peut-être nos certitudes informatiques qui vacilleront, redessinées par la logique quantique.